一 URLLIB

URL,即统一资源定位符,也就是我们说的网址, 互联网上的每个文件都有一个唯一的URL。

URL的格式由三部分组成:

①第一部分是协议(或称为服务方式)。

②第二部分是存有该资源的主机IP地址(有时也包括端口号)。

③第三部分是主机资源的具体地址,如目录和文件名等。

import urllib2

import urllib

#定义字典

values = {'action' : 'login', 'name': '王一妃', 'password' : '000000'}

# #定义字典方式二

#

# values = {}

# values['username'] = "catherine199787@outlook.com"

# values['password'] = "000000"

#有些网站会对ip访问次数限制

# enable_proxy = True

# proxy_handler = urllib2.ProxyHandler({"http" : 'http://some-proxy.com:8080'})

# null_proxy_handler = urllib2.ProxyHandler({})

# if enable_proxy:

# opener = urllib2.build_opener(proxy_handler)

# else:

# opener = urllib2.build_opener(null_proxy_handler)

# urllib2.install_opener(opener)

#写入请求身份

#有些服务器或 Proxy 会通过该值来判断是否是浏览器发出的请求

user_agent = "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/53.0.2785.116 Safari/537.36"

headers = { 'User-Agent' : user_agent}

#对付反盗链

#headers = { 'User-Agent' : user_agent, 'Referer':'http://www.zhihu.com/articles' }

#编码字典

data = urllib.urlencode(values)

url = "http://cs.xiyoulinux.org/server/login.server.php"

#http协议有六种请求方法,get,head,put,delete,post,options

#get

# geturl = url + "?"+data

# request = urllib2.Request(geturl)

#print geturl #打印

#post

request = urllib2.Request(url, data, headers)

#如果第二个参数data为空那么要特别指定是timeout是多少

response = urllib2.urlopen(request, timeout = 10)

print response.read()二 URLERROR

URLError可能产生的原因:

1.网络无连接,即本机无法上网

2.连接不到特定的服务器

3.服务器不存在

一个简单的例子,访问一个乱七八糟的url会显示:[Errno 11004] getaddrinfo failed

#URLerror

# requset = urllib2.Request('http://www.xxxxx.com')

# try:

# urllib2.urlopen(requset)

# except urllib2.URLError, e:

# print e.reasonHTTPError是URLError的子类。

在你利用urlopen方法发出一个请求时,服务器上都会对应一个应答对象response,其中它包含一个数字”状态码”。

当这个“码”不能处理的,urlopen会产生一个HTTPError,对应相应的状态码,HTTP状态码表示HTTP协议所返回的响应的状态。

这个程序打印出

403

Forbidden

意思是服务器禁止访问。

#HTTPerror

# req = urllib2.Request('http://blog.csdn.net/cqcre')

# try:

# urllib2.urlopen(req)

# except urllib2.HTTPError, e:

# print e.code

# print e.reason

403这个数字经常见,其他的状态码意义如下:

100:继续 客户端应当继续发送请求。客户端应当继续发送请求的剩余部分,或者如果请求已经完成,忽略这个响应。

101: 转换协议 在发送完这个响应最后的空行后,服务器将会切换到在Upgrade 消息头中定义的那些协议。只有在切换新的协议更有好处的时候才应该采取类似措施。

102:继续处理 由WebDAV(RFC 2518)扩展的状态码,代表处理将被继续执行。

200:请求成功 处理方式:获得响应的内容,进行处理

201:请求完成,结果是创建了新资源。新创建资源的URI可在响应的实体中得到 处理方式:爬虫中不会遇到

202:请求被接受,但处理尚未完成 处理方式:阻塞等待

204:服务器端已经实现了请求,但是没有返回新的信 息。如果客户是用户代理,则无须为此更新自身的文档视图。 处理方式:丢弃

300:该状态码不被HTTP/1.0的应用程序直接使用, 只是作为3XX类型回应的默认解释。存在多个可用的被请求资源。 处理方式:若程序中能够处理,则进行进一步处理,如果程序中不能处理,则丢弃

301:请求到的资源都会分配一个永久的URL,这样就可以在将来通过该URL来访问此资源 处理方式:重定向到分配的URL

302:请求到的资源在一个不同的URL处临时保存 处理方式:重定向到临时的URL

304:请求的资源未更新 处理方式:丢弃

400:非法请求 处理方式:丢弃

401:未授权 处理方式:丢弃

403:禁止 处理方式:丢弃

404:没有找到 处理方式:丢弃

500:服务器内部错误 服务器遇到了一个未曾预料的状况,导致了它无法完成对请求的处理。一般来说,这个问题都会在服务器端的源代码出现错误时出现。

501:服务器无法识别 服务器不支持当前请求所需要的某个功能。当服务器无法识别请求的方法,并且无法支持其对任何资源的请求。

502:错误网关 作为网关或者代理工作的服务器尝试执行请求时,从上游服务器接收到无效的响应。

503:服务出错 由于临时的服务器维护或者过载,服务器当前无法处理请求。这个状况是临时的,并且将在一段时间以后恢复。

因为HTTPError的父类是URLError,如果捕获到了HTTPError,则输出code,不会再处理URLError异常。如果发生的不是HTTPError,则会去捕获URLError异常,输出错误原因。

根据编程经验,父类的异常应当写到子类异常的后面,这个程序只会输出403

req = urllib2.Request('http://blog.csdn.net/cqcre')

try:

urllib2.urlopen(req)

except urllib2.HTTPError, e:

print e.code

except urllib2.URLError, e:

print e.reason

else:

print "OK"或者也可以加入hasattr属性提前对属性进行判断,输出是一样的。

req = urllib2.Request('http://blog.csdn.net/cqcre')

try:

urllib2.urlopen(req)

except urllib2.URLError, e:

if hasattr(e, "code"):

print e.code

if hasattr(e, "reason"):

print e.reason

else:

print "OK"三 cookie

Cookie,指储存在用户本地终端上的数据,不是登录后之后浏览器会问你是否记住这个密码,以后就可以直接登陆了,我猜想这就是cookie

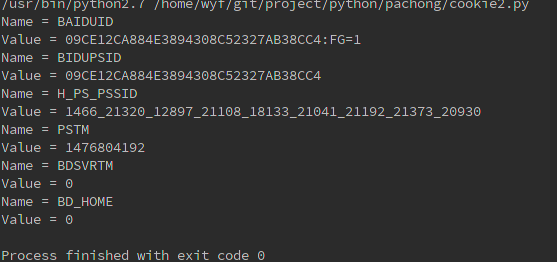

你可以将cookie保存到一个变量中,因为cookie文件可以迭代,所以用的是for循环

import urllib

import urllib2

import cookielib

#声明一个CookieJar对象实例来保存cookie

cookie = cookielib.CookieJar()

#利用urllib2库的HTTPCookieProcessor对象来创建cookie处理器

handler=urllib2.HTTPCookieProcessor(cookie)

#通过handler来构建opener

opener = urllib2.build_opener(handler)

#此处的open方法同urllib2的urlopen方法,也可以传入request

response = opener.open('http://www.baidu.com')

for item in cookie:

print 'Name = '+item.name

print 'Value = '+item.value运行后打印

又或者保存到文件中

#设置保存cookie的文件,同级目录下的cookie.txt

filename = 'cookie.txt'

#声明一个MozillaCookieJar对象实例来保存cookie,之后写入文件

cookie = cookielib.MozillaCookieJar(filename)

#利用urllib2库的HTTPCookieProcessor对象来创建cookie处理器

handler=urllib2.HTTPCookieProcessor(cookie)

#通过handler来构建opener

opener = urllib2.build_opener(handler)

#此处的open方法同urllib2的urlopen方法,也可以传入request

response = opener.open('http://222.24.62.120/default2.aspx')

print response.read()

#保存cookie到文件

#ignore_discard: save even cookies set to be discarded.

#ignore_expires: save even cookies that have expiredThe file is overwritten if it already exists

cookie.save(ignore_discard=True, ignore_expires=True)当你用的时候就可以去获取cookie

#创建MozillaCookieJar实例对象

cookie = cookielib.MozillaCookieJar()

#从文件中读取cookie内容到变量

cookie.load('cookie.txt', ignore_discard = True, ignore_expires = True)

#创建请求的request

request = urllib2.Request("http://222.24.62.120/default2.aspx")

#利用urllib2的build_opener方法创建一个opener

opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cookie))

response = opener.open(request)

print response.read()将他们结合起来你就可以使用cookie去登录一个网站了,拿我们小组的cs为例

使用cookie登录

filename = 'cookie.txt'

cookie = cookielib.MozillaCookieJar(filename)

opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cookie))

postdata = urllib.urlencode({

'txtUserName':'04153161',

'TextBox2':'ting199787'

})

#登录小组的URL

loginUrl = 'http://cs.xiyoulinux.org/server/login.server.php'

#模拟登录,并把cookie保存到变量

result = opener.open(loginUrl,postdata)

#保存cookie到cookie.txt中

cookie.save(ignore_discard=True, ignore_expires=True)

#利用cookie请求访问另一个网址,此网址是群博

gradeUrl = 'http://blog.xiyoulinux.org/'

#请求访问群博网址

result = opener.open(gradeUrl)

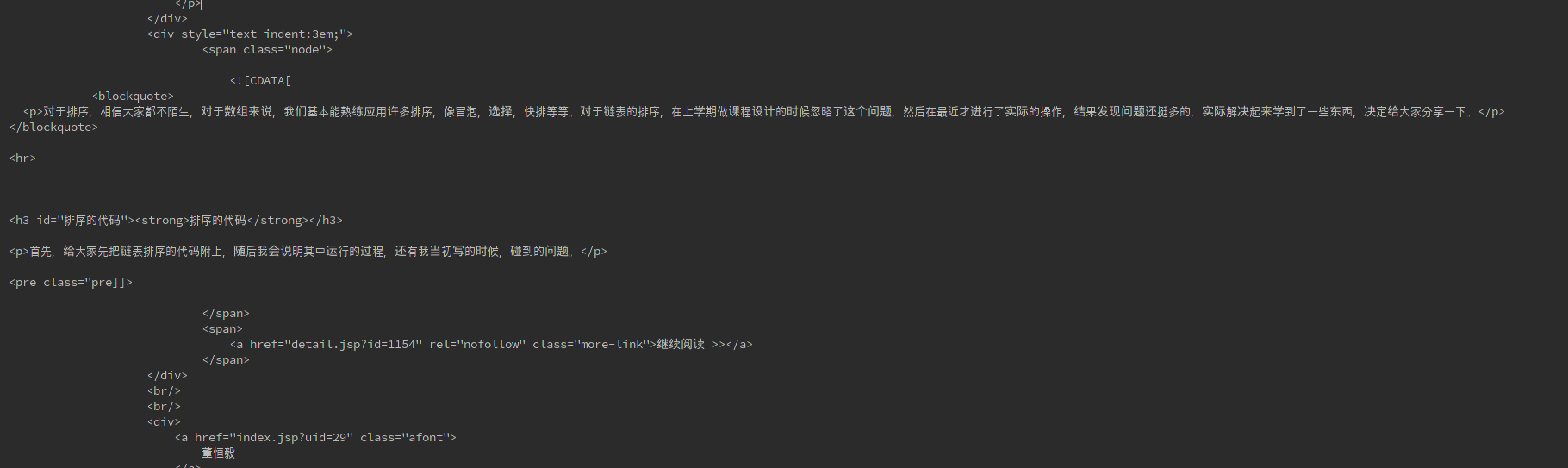

print result.read()可以看到DHY发的微博

0.0